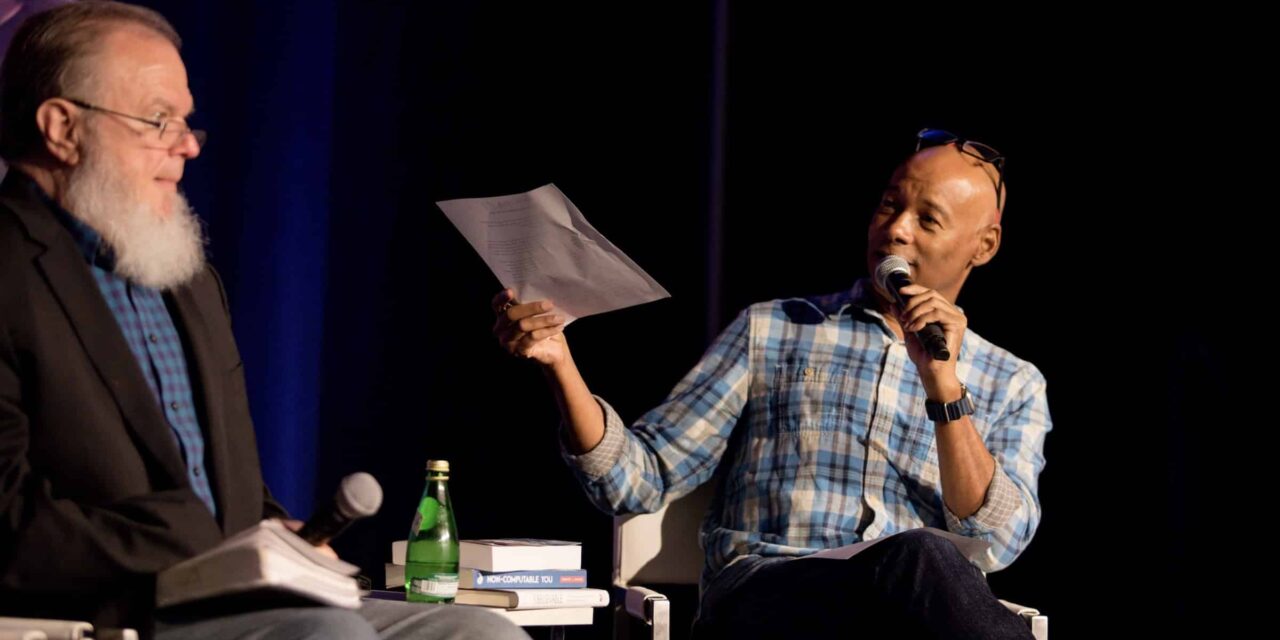

La reciente conferencia COSM 2023 del Discovery Institute organizó un panel sobre «Los límites y posibilidades por excelencia de la IA», que abordó una de las preguntas fundamentales que COSM busca investigar: «¿Es la inteligencia artificial ‘generativa’ o degenerativa?» Si estos expertos tienen razón, la I.A. podría estar condenada a degenerarse en un futuro hacia un sin sentido.

George Montañez, profesor asistente de Ciencias de la Computación en Harvey Mudd College, abrió la sesión explicando cómo funciona la IA. Las IA modernas y sus “grandes modelos de lenguaje” (LLM, por sus siglas en inglés) se entrenan con enormes conjuntos de datos del mundo real, es decir, textos e imágenes generados por humanos. El panelista William Dembski, matemático y filósofo, señaló que estos LLM “requieren una gran cantidad de datos de entrada y capacitación” para funcionar. Por ejemplo, señala que se necesitó una inmensa cantidad de datos, tiempo, dinero y daños colaterales a los humanos para entrenar a la IA para que reconociera y rechazara la pornografía. De manera similar, el ingeniero de software Walter Myers señaló en el panel que ChatGPT tuvo que entrenar con millones de imágenes de perros y gatos antes de poder reconocerlos de manera confiable. Por el contrario, Montañez señala que un niño humano puede ver algunas imágenes de un animal e inmediatamente es capaz de reconocer esa especie como vida.

Montañez explicó además que después de suficiente entrenamiento, la IA puede interpretar datos «más allá de las cosas que ve», pero esto sólo se debe a «sesgos y suposiciones» proporcionadas por los humanos que programan la IA con estas capacidades. Esto significa que “las huellas dactilares humanas están por todas partes” en las capacidades de la IA, y “por muy impresionantes que sean estos sistemas”, son “altamente parásitos de la racionalidad y la creatividad humanas”. Montañez puso el ejemplo de una IA que remezcla rap con Shakespeare. «Podrías pensar que es asombroso», pero la realidad es que «todo se basa en la programación humana».

Colapso del modelo

Pero entrenar la IA en grandes conjuntos de datos tiene un inconveniente llamado «colapso del modelo». En resumen, la IA funciona porque los humanos son verdaderos seres creativos, y las IA se construyen utilizando cantidades gigantescas de conjuntos de datos diversos y creativos creados por humanos sobre los cuales pueden entrenarse y comenzar a pensar y razonar como un humano. Hasta ahora esto ha sido posible porque el ser humano ha creado casi todo lo que vemos en Internet. Mientras las IA rastrean todo Internet, pueden confiar en que prácticamente todo lo que encuentran fue creado originalmente por seres inteligentes y creativos (es decir, humanos). Entrene a la IA en esas cosas y comenzará a parecer inteligente y creativa (incluso si en realidad no lo es).

Pero, ¿qué pasará a medida que los humanos se vuelvan más dependientes de la IA y que Internet se llene cada vez más de material generado por IA? Si la IA continúa entrenándose con cualquier cosa que encuentre en Internet, pero la red es cada vez más un paisaje generado por IA, entonces la IA terminará entrenándose sobre sí misma. Sabemos lo que sucede cuando las IA se entrenan en sí mismas en lugar de en los productos de humanos realmente inteligentes, y no es agradable. Este es el colapso del modelo.

Ingresa Robert J. Marks, Profesor Distinguido de Ingeniería Eléctrica e Informática en la Universidad de Baylor. Señaló que en el primer día de COSM 23, el científico informático y pionero de la IA, Stephen Wolfram, advirtió que estamos al límite de los datos de entrenamiento disponibles para la IA; esencialmente, estamos alcanzando los límites de lo que podemos alimentar a la IA para hacerla inteligente. . Una vez que la IA se quede sin datos de entrenamiento, ¿qué hará: entrenarse a sí misma?

Después de llevar a la audiencia a través de una breve historia de la informática y el desarrollo de la IA, Marks señaló que “cada salto [en la capacidad informática] fue realizado por humanos, no por la IA. Cada salto en la IA se debió al ingenio humano”. Pero cuando la IA se quede sin ingenio humano para entrenar, ¿alcanzará un límite, es decir, el colapso del modelo? Como dijo Montañez, «Después de que hemos eliminado de la red todos los datos de entrenamiento humano», entonces «comienza a eliminar los datos generados por la IA» porque «eso es todo lo que tienes». Ahí es cuando se produce el colapso del modelo, y es posible que estemos acercándonos a él.

Marks citó un estudio publicado recientemente en Arxiv.org, “La maldición de la recursión: el entrenamiento en datos generados hace que los modelos olviden”, que muestra el colapso del modelo en acción. Una “generación” inicial de IA se entrena directamente con datos creados por humanos y su resultado generalmente tiene sentido. Pero después de varias generaciones de entrenamiento de IA sobre sí misma, el resultado es un galimatías obsesionado con liebres de colores sin sentido:

Además de ser el hogar de algunas de las poblaciones más grandes del mundo de conejos de cola @-@ negros, conejos de cola @-@ blancos, conejos de cola @-@ azules, conejos de cola @-@ rojos y conejos de cola @-@ amarillos.

Un fenómeno similar ocurre con las imágenes. Marks mostró cómo una IA entrenada para hacer variaciones creativas de la pintura de Mona Lisa inicialmente proporciona algunas imágenes interesantes, aunque quizás inquietantes. Pero eventualmente, a medida que se entrena con su propio material, no terminas con arte sino con líneas y manchas sin sentido.

Endogamia digital

El problema del colapso del modelo no es del todo distinto de la genética humana, donde se advierte a hermanos o primos que nunca se casen porque ambos portan las mismas mutaciones nocivas que, cuando se combinan, producirán descendencia malformada. Es mejor casarse con alguien fuera de su acervo genético inmediato, porque probablemente tendrá “material genético nuevo” que puede combinarse con el suyo para tener hijos sanos.

De manera similar, el entrenamiento de la IA sobre sí misma necesita material creativo nuevo sobre el cual entrenar o, de lo contrario, los algoritmos terminarán alimentándose de sí mismos en ciclos recursivos que degenerarán en tonterías. Como lo expresó recientemente Popular Mechanics, la IA terminará “comiéndose su propia cola”.

Para mezclar metáforas, la amenaza del colapso del modelo es similar a la endogamia digital, y garantiza que sin que los humanos proporcionen constantemente material creativo nuevo para que las IA se entrenen, las IA están condenadas a deteriorarse. Por lo tanto, su creatividad puede verse limitada por los conjuntos de datos humanos que se les proporcionan, lo que significa que existen límites básicos a lo que la IA puede hacer. La IA nunca superará a los humanos en aspectos fundamentales y siempre estará limitada por lo que puedan aprender de nosotros.

Artículo publicado originalmente por Casey Luskin Ph.D. en Evolution News & Science Today